移动终端催生芯片需求

移动终端,尤其是智能手机的快速进步,使得人们对于在设备上应用人工智能的渴望愈发迫切。这种需求导致了对硬件计算性能和能耗控制提出了极高的标准。试想,我们日常使用的手机能够完成智能语音对话、图像识别等功能,这一切都依赖于高性能芯片的强大支持。

2023年,全球智能手机销量超过十亿部。庞大的用户基数对芯片性能提出了更高要求。这推动了芯片行业加快技术革新步伐,以便更好地满足市场需求。

当前主流芯片类型

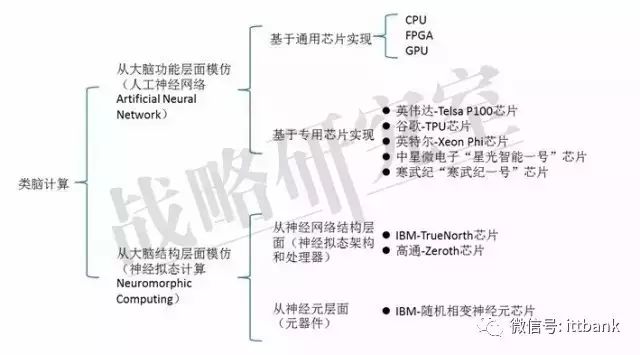

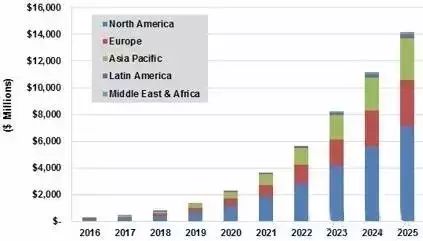

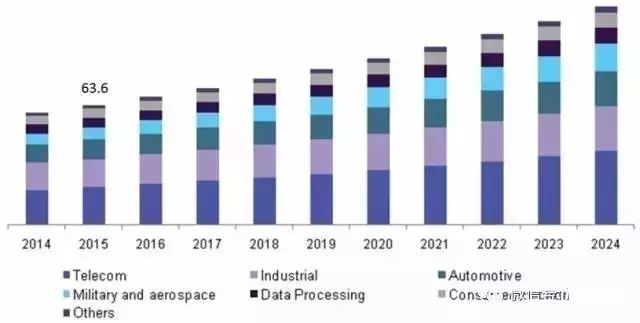

当前,人工智能行业普遍采用CPU、GPU以及FPGA等通用型芯片。这些芯片如同多功能的工具,可在各种人工智能应用场景中施展其能。此外,Intel、Google、英伟达等公司还推出了专为神经网络算法设计的专用芯片ASIC。尽管目前通用芯片占据市场主导地位,但预计在接下来的几年里,ASIC芯片将有望成为市场的主流,从而改写市场格局。

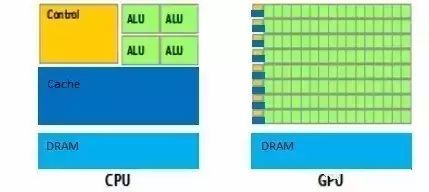

通用CPU的局限性

传统的通用CPU在执行人工智能算法方面存在不足。其计算指令是按顺序依次执行,宛如排队办事一般,无法充分利用芯片的性能。因此,在处理复杂的人工智能任务时,效率会显著降低。在现今这个追求高效快捷的时代,这种局限显得尤为明显,迫切需要更合适的芯片来取代。

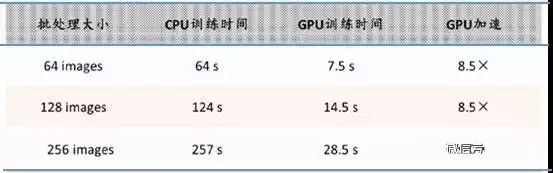

英伟达的GPU布局

2010年,英伟达便开始在人工智能产品领域展开布局。到了2014年,他们推出了新一代的PASCAL GPU芯片架构,这是他们第五代的GPU架构。尤为关键的是,这款GPU是专为深度学习设计的,并且兼容所有主流的深度学习计算框架。这些举措使得英伟达在人工智能芯片领域占据了关键位置,并为未来的发展奠定了坚实的基础。

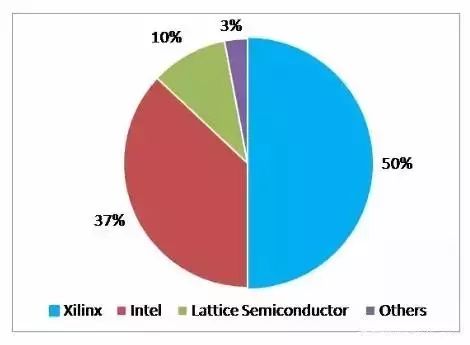

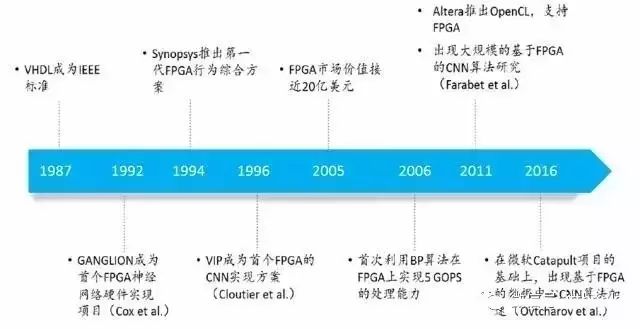

FPGA芯片的优势

FPGA芯片有其独到之处。它的单次投入成本比ASIC要低得多。在芯片需求尚未达到规模,深度学习算法尚不稳定,需要持续迭代优化的情形下,FPGA芯片显得尤为合适。这类半定制芯片基于FPGA平台,通过抽象出的指令集和编译器,能实现快速的开发与迭代,其竞争力甚至超过了专门的FPGA加速器产品。随着人工智能技术的迅猛进步和算法的持续更新,FPGA芯片展现出更强的市场适应性。

芯片发展的不同阶段

在深度学习算法的全定制阶段,芯片应用了ASIC设计技术进行全定制。这种设计使得芯片在处理深度学习算法时,性能、功耗和面积等关键指标都能达到最佳状态。在类脑计算领域,芯片设计的初衷已不单纯是为了加快深度学习算法的运行速度。我们期望在芯片的基础结构和器件层面,探索并创造出全新的类脑计算机架构。例如,我们可能会运用忆阻器和ReRAM等新型器件来提升存储的密度,这样的创新将为人工智能的进步带来新的飞跃。

你觉得人工智能芯片将来会在哪些方面引发重大改变?欢迎在评论区留下你的看法。同时,请不要忘记给我们点个赞,并将这篇文章分享出去。